Chain of Verification (CoVe): Nâng Cao Độ Tin Cậy Của Mô Hình Ngôn Ngữ Lớn

Blog . TutorialsContents

Chào mừng bạn đến với Fx Studio. Các Mô hình Ngôn ngữ Lớn (LLM) như GPT-4 đã tạo ra một cuộc cách mạng trong việc tạo ra văn bản giống như con người. Tuy nhiên, chúng có một điểm yếu cố hữu là “hallucination” (ảo giác hay bịa đặt thông tin). Để giải quyết vấn đề này, các nhà nghiên cứu đã phát triển một kỹ thuật prompting tiên tiến gọi là Chain of Verification (Chuỗi Xác Minh – CoVe).

Bài viết này sẽ giải thích CoVe là gì, tại sao nó lại quan trọng, và cách áp dụng nó thông qua các ví dụ cụ thể.

Giới Thiệu Về Chain-of-Verification (CoVe)

Chain-of-Verification (CoVe) là một kỹ thuật prompt engineering tiên tiến, được thiết kế để giải quyết một trong những thách thức lớn nhất của các mô hình ngôn ngữ lớn (LLM): hiện tượng “ảo giác” (hallucination). Hiện tượng này xảy ra khi mô hình tạo ra thông tin có vẻ hợp lý nhưng thực tế lại sai lệch hoặc hoàn toàn bịa đặt.

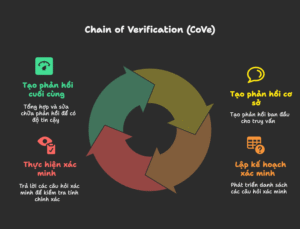

CoVe hoạt động như một quy trình tự kiểm tra có cấu trúc. Thay vì đưa ra câu trả lời ngay lập tức, mô hình được hướng dẫn để thực hiện một chuỗi các bước: tạo ra một câu trả lời ban đầu, sau đó tự lập kế hoạch kiểm tra, thực hiện việc xác minh các dữ kiện trong câu trả lời đó, và cuối cùng là tổng hợp lại để đưa ra một phiên bản cuối cùng đã được sửa chữa và đáng tin cậy hơn.

Về cơ bản, CoVe dựa trên triết lý rằng một mô hình ngôn ngữ đủ mạnh có khả năng tự phê bình và sửa lỗi nếu được “prompt” đúng cách. Bằng cách chia nhỏ quá trình trả lời thành các bước có thể kiểm soát, CoVe giúp giảm thiểu rủi ro sai sót và tăng cường độ chính xác, đặc biệt trong các nhiệm vụ đòi hỏi tính xác thực cao như trả lời câu hỏi, kiểm chứng thông tin, hay tạo nội dung chuyên sâu.

Vấn Đề Cốt Lõi: Hiện Tượng “Hallucination”

Khi bạn hỏi một LLM một câu hỏi, nó không “biết” câu trả lời theo cách con người biết. Thay vào đó, nó dự đoán từ tiếp theo dựa trên xác suất từ kho dữ liệu khổng lồ mà nó đã được huấn luyện. Quá trình này đôi khi dẫn đến việc mô hình tự tin “sáng tạo” ra các sự kiện, ngày tháng, hoặc chi tiết không chính xác.

Chain of Verification được thiết kế để giảm thiểu rủi ro này bằng cách buộc mô hình phải tự kiểm tra lại các thông tin mà chính nó đưa ra.

CoVe Hoạt Động Như Thế Nào?

CoVe hoạt động bằng cách chia quá trình trả lời thành nhiều bước, mô phỏng cách một người cẩn thận kiểm tra thông tin:

- Tạo Câu Trả Lời Cơ Sở (Generate Baseline Response): Đầu tiên, LLM sẽ tạo ra một câu trả lời ban đầu cho câu hỏi của người dùng.

- Lên Kế Hoạch Xác Minh (Plan Verifications): Dựa trên câu trả lời cơ sở, LLM tự đặt ra một loạt câu hỏi xác minh để kiểm tra tính đúng đắn của các chi tiết quan trọng trong câu trả lời đó.

- Thực Hiện Xác Minh (Execute Verifications): LLM trả lời các câu hỏi xác minh mà nó vừa đặt ra. Bước này giúp nó đối chiếu và tìm ra những điểm không nhất quán hoặc sai sót.

- Tạo Câu Trả Lời Cuối Cùng (Generate Final Verified Response): LLM tổng hợp câu trả lời cơ sở và kết quả từ bước xác minh để đưa ra một câu trả lời cuối cùng, đã được sửa chữa và đáng tin cậy hơn.

So Sánh Các Phương Pháp Áp Dụng CoVe

Việc chia nhỏ các bước trong CoVe rõ ràng giúp giảm hallucination hiệu quả hơn so với việc dùng một prompt duy nhất. Khi mô hình phải thực hiện từng bước, nó buộc phải “suy nghĩ” và đối chiếu các sự thật một cách độc lập.

Để minh họa, chúng ta sẽ sử dụng một câu hỏi thống nhất: “Kể tên một số chính trị gia sinh tại New York”. Giả sử phản hồi ban đầu của mô hình có thể chứa lỗi.

1. Phương pháp Joint (Kết hợp)

Phương pháp này kết hợp toàn bộ quy trình vào một prompt duy nhất. Nó đơn giản nhưng có thể kém chính xác hơn do mọi thứ nằm trong cùng một ngữ cảnh.

Mẫu Prompt (một prompt duy nhất):

Trả lời câu hỏi: “Kể tên một số chính trị gia sinh tại New York”.

Sau đó, dựa trên phản hồi của bạn, tạo danh sách các câu hỏi xác minh để kiểm tra độ chính xác (ví dụ: hỏi nơi sinh của từng người).

Tiếp theo, trả lời từng câu hỏi xác minh một cách độc lập.

Cuối cùng, dựa trên kết quả xác minh, sửa chữa và tạo phản hồi cuối cùng chính xác.

Kết quả dự kiến: Mô hình sẽ tự xử lý tất cả trong một lần. Phản hồi ban đầu có thể liệt kê Donald Trump, Franklin D. Roosevelt, Hillary Clinton. Sau khi tự xác minh, nó có thể phát hiện Hillary Clinton sinh ở Chicago và loại bà ra khỏi câu trả lời cuối cùng.

2. Phương pháp 2-Step (Hai Bước)

Phương pháp này chia thành hai prompt riêng biệt:

-

Prompt 1 để lập kế hoạch xác minh

-

Prompt 2 để thực hiện xác minh và tạo phản hồi cuối cùng.

Nó giúp giảm thiên vị bằng cách tách ngữ cảnh.

Prompt 1 (Lập kế hoạch xác minh):

Dựa trên phản hồi ban đầu: “Một số chính trị gia sinh tại New York: Donald Trump, Franklin D. Roosevelt, Hillary Clinton”.

Tạo danh sách các câu hỏi xác minh để kiểm tra độ chính xác, ví dụ: hỏi nơi sinh của từng người.

Prompt 2 (Thực hiện xác minh và sửa chữa):

Dựa trên các câu hỏi xác minh sau:

1. Donald Trump sinh ở đâu?

2. Franklin D. Roosevelt sinh ở đâu?

3. Hillary Clinton sinh ở đâu?

Trả lời từng câu một cách độc lập. Sau đó, dựa trên kết quả, sửa chữa phản hồi ban đầu và tạo phản hồi cuối cùng chính xác cho câu hỏi gốc: “Kể tên một số chính trị gia sinh tại New York”.

3. Phương pháp Factored (Phân Tách)

Phương pháp này phân tách tối đa, với prompt riêng cho từng câu hỏi xác minh, sau đó một prompt cuối để tổng hợp. Nó đảm bảo tính độc lập cao, giảm hallucination hiệu quả nhất nhưng tốn nhiều lần gọi mô hình.

Prompt 1 (Tạo câu trả lời ban đầu):

Kể tên một số chính trị gia sinh tại New York.

Prompt 2 (Lập kế hoạch xác minh):

Dựa trên phản hồi ban đầu: “Một số chính trị gia sinh tại New York: Donald Trump, Franklin D. Roosevelt, Hillary Clinton”.

Tạo danh sách các câu hỏi xác minh để kiểm tra.

Prompt 3, 4, 5 (Xác minh riêng lẻ):

Trả lời độc lập: Donald Trump sinh ở đâu?

Trả lời độc lập: Franklin D. Roosevelt sinh ở đâu?

Trả lời độc lập: Hillary Clinton sinh ở đâu?

Prompt cuối (Tạo phản hồi cuối cùng):

Dựa trên kết quả xác minh:

– Donald Trump sinh ở Queens, New York.

– Franklin D. Roosevelt sinh ở Hyde Park, New York.

– Hillary Clinton sinh ở Chicago, Illinois.

Sửa chữa và tạo phản hồi cuối cùng chính xác cho câu hỏi: “Kể tên một số chính trị gia sinh tại New York”.

4.Phương pháp Factor + Revise (Phân Tách và Sửa Chữa)

Tương tự Factored nhưng thêm một bước “sửa chữa” tường minh để kiểm tra sự không nhất quán, giúp tăng độ tin cậy. Các prompt lập kế hoạch và xác minh riêng lẻ tương tự phương pháp Factored.

Prompt thêm cho việc sửa chữa (sau khi có kết quả xác minh):

Phản hồi ban đầu: “Một số chính trị gia sinh tại New York: Donald Trump, Franklin D. Roosevelt, Hillary Clinton”.

Kết quả xác minh:

– Donald Trump: Queens, New York.

– Franklin D. Roosevelt: Hyde Park, New York.

– Hillary Clinton: Chicago, Illinois.

Hãy kiểm tra sự không nhất quán giữa phản hồi ban đầu và kết quả xác minh, sau đó tạo phản hồi cuối cùng đã được sửa chữa và chính xác.

5. Phương pháp CoT + CoVe (Kết Hợp Với Chain-of-Thought)

Phương pháp này tích hợp CoVe vào Chain-of-Thought (CoT) trong một prompt duy nhất, khuyến khích mô hình suy nghĩ từng bước logic kèm xác minh.

Mẫu Prompt (một prompt duy nhất):

Suy nghĩ từng bước để trả lời câu hỏi: “Kể tên một số chính trị gia sinh tại New York”.

Bước 1: Tạo một danh sách các ứng viên tiềm năng.

Bước 2: Với mỗi ứng viên, đặt câu hỏi xác minh về nơi sinh của họ.

Bước 3: Trả lời từng câu hỏi xác minh.

Bước 4: Dựa trên kết quả xác minh, lọc danh sách và đưa ra phản hồi cuối cùng.

Kết quả dự kiến: Mô hình sẽ “nghĩ” chi tiết, ví dụ: “Okay, hãy bắt đầu. Các chính trị gia nổi tiếng liên quan đến New York có thể là Trump, Roosevelt, Clinton. Giờ hãy kiểm tra. Trump sinh ở đâu? Queens, NY. Đúng. Roosevelt? Hyde Park, NY. Đúng. Clinton? Chicago. Sai. Vậy danh sách cuối cùng là Donald Trump và Franklin D. Roosevelt.”

Ưu điểm và Lợi ích của CoVe

- Tăng cường độ chính xác: Giảm đáng kể số lượng thông tin sai lệch và “ảo giác”.

- Tăng tính minh bạch: Cho phép người dùng thấy được cách mô hình kiểm tra thông tin.

- Xây dựng niềm tin: Người dùng có xu hướng tin tưởng hơn vào câu trả lời đã qua kiểm tra.

- Khả năng tự sửa lỗi: Cung cấp cho mô hình cơ chế tự nhận ra và sửa chữa sai lầm.

- Không cần huấn luyện lại: Là một kỹ thuật prompting, có thể áp dụng cho các mô hình có sẵn.

Hạn chế và Thách thức

- Tăng chi phí và độ trễ: Quy trình nhiều bước yêu cầu nhiều lệnh gọi đến mô hình hơn.

- Không loại bỏ hoàn toàn sai sót: Chỉ giúp giảm thiểu chứ không thể loại bỏ 100% ảo giác.

- Tập trung vào dữ kiện, không phải logic: Kém hiệu quả hơn trong việc phát hiện các lỗi sai trong lập luận phức tạp.

- Phụ thuộc vào năng lực của mô hình: Hiệu quả của CoVe phụ thuộc vào chất lượng của mô hình ngôn ngữ cơ sở.

Ứng dụng thực tế

Với khả năng tăng cường tính chính xác của dữ kiện, CoVe đặc biệt hữu ích trong các lĩnh vực mà độ tin cậy của thông tin là yếu tố sống còn.

- Báo chí và Kiểm chứng thông tin (Fact-checking): Tự động kiểm tra các dữ kiện, ngày tháng, tên riêng và các tuyên bố trong các bài báo trước khi xuất bản để giảm thiểu thông tin sai lệch.

- Y tế và Chăm sóc sức khỏe: Hỗ trợ bác sĩ bằng cách cung cấp các bản tóm tắt bệnh án, chẩn đoán sơ bộ và kiểm tra chéo các thông tin đó với kiến thức y khoa hiện có để đảm bảo tính chính xác.

- Nghiên cứu pháp lý: Hỗ trợ luật sư bằng cách xác thực các trích dẫn luật, án lệ và các nguyên tắc pháp lý trong các tài liệu, giảm thiểu rủi ro do trích dẫn sai.

- Hệ thống Hỏi-Đáp (QA Systems): Cải thiện đáng kể độ tin cậy của các câu trả lời cho các câu hỏi dựa trên dữ kiện, đặc biệt trong các trợ lý ảo doanh nghiệp hoặc các công cụ tìm kiếm thông minh.

- Tạo nội dung dài (Long-form generation): Đảm bảo tính chính xác của các báo cáo tài chính, tài liệu kỹ thuật, sách trắng hoặc các bài viết chuyên sâu khác.

Kết Luận

Chain of Verification là một công cụ mạnh mẽ để tăng cường tính xác thực cho các mô hình ngôn ngữ lớn. Việc lựa chọn phương pháp phù hợp và nhận thức rõ về các ưu, nhược điểm của nó sẽ giúp người dùng khai thác tối đa tiềm năng của kỹ thuật này, góp phần xây dựng một tương lai AI minh bạch và đáng tin cậy hơn.

Tham khảo:

Okay! Tới đây, mình xin kết thúc bài viết này. Nếu có gì thắc mắc hay góp ý cho mình. Thì bạn có thể để lại bình luận hoặc gửi email theo trang Contact.

Cảm ơn bạn đã đọc bài viết này!

Related Posts:

Written by chuotfx

Hãy ngồi xuống, uống miếng bánh và ăn miếng trà. Chúng ta cùng nhau đàm đạo về đời, về code nhóe!

1 comment

Leave a Reply Cancel reply

Fan page

Tags

Recent Posts

- God of Vibe Coding

- Cái Chết & Ý Nghĩa Của Sự Tồn Tại – Góc Nhìn Của Một Lập Trình Viên

- Hướng Dẫn Kỹ Thuật Ngữ Cảnh WSCI & Cấu Trúc Workspace

- The Divine Triad Synergy – Sức Mạnh Tam Giác Meta Skills

- Skill Validator – Đấng Phán Xét Chân Lý

- Self-Healing Systems – Khi Code Tự “Chữa Lành”

- Skill Writer – Nghệ Nhân Soạn Thảo

- Skill Creator – Đấng Sáng Tạo Muôn Kỹ Năng

- AntiGravity Skills Là Gì? – Định Nghĩa Của Sự Tự Do

- Thiết Kế AI_CONTEXT.md — Nghệ Thuật Giao Tiếp Với AI Qua Tài Liệu

You may also like:

Archives

- February 2026 (1)

- January 2026 (10)

- December 2025 (1)

- October 2025 (1)

- September 2025 (4)

- August 2025 (5)

- July 2025 (10)

- June 2025 (1)

- May 2025 (2)

- April 2025 (1)

- March 2025 (8)

- January 2025 (7)

- December 2024 (4)

- September 2024 (1)

- July 2024 (1)

- June 2024 (1)

- May 2024 (4)

- April 2024 (2)

- March 2024 (5)

- January 2024 (4)

- February 2023 (1)

- January 2023 (2)

- November 2022 (2)

- October 2022 (1)

- September 2022 (5)

- August 2022 (6)

- July 2022 (7)

- June 2022 (8)

- May 2022 (5)

- April 2022 (1)

- March 2022 (3)

- February 2022 (5)

- January 2022 (4)

- December 2021 (6)

- November 2021 (8)

- October 2021 (8)

- September 2021 (8)

- August 2021 (8)

- July 2021 (9)

- June 2021 (8)

- May 2021 (7)

- April 2021 (11)

- March 2021 (12)

- February 2021 (3)

- January 2021 (3)

- December 2020 (3)

- November 2020 (9)

- October 2020 (7)

- September 2020 (17)

- August 2020 (1)

- July 2020 (3)

- June 2020 (1)

- May 2020 (2)

- April 2020 (3)

- March 2020 (20)

- February 2020 (5)

- January 2020 (2)

- December 2019 (12)

- November 2019 (12)

- October 2019 (19)

- September 2019 (17)

- August 2019 (10)